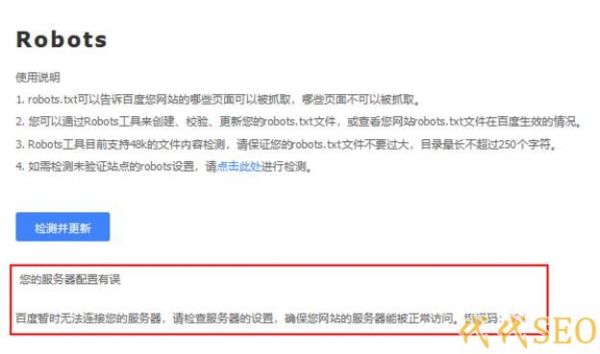

今天我们来讲解一个小问题,很多朋友更新了robots.txt文件以后,然后去百度站长平台监测 robots.txt是否正确,却被提示:百度暂时无法链接服务器,错误301代码,这个时候我们应该怎么解 决那?其实解决方法并不是很难,今天就教大家排查这个问题。

1,服务器是否可以正常访问!

我们最先检查的应该是我们的服务器,手动访问,看是否可以打开,或者是否打开非常慢,所造成 百度抓取延迟,才导致的抓取失败,大家可以用17测,来检测网站的整体速度,如果发现网站异常慢的 话,就应该联系你的服务商进行排查问题了,问题排查后,恢复正常,大家在进行检测robots.txt,就 可以恢复正常了。

2,检查域名是否为首选域,301导致的错误!

如果服务器没有问题,大家就检查下是不是首选域的问题,比如你在站长平台绑定的域名是你的顶级域名,而访问网站却是你的www域名,百度站长平台访问的时候,可能就会提示抓取错误,如果是这个问题,建议重新绑定站长平台域名来解决即可。

3,检测robots.txt,是否在根目录!

如果以上没问题,请检查你的robots.txt是否在网站根目,很多朋友都容易放错,误以为robots.txt放在那里都是可以的,其实这个文件是必须放到根目录的,这个大家要注意。

4,检查robots.txt是否为空

如果robots.txt文件位置没有错,我们就要检查下robots.txt是否为空文件,可能再上传或者直接修改时,造成了文件的错误而导致为空,这种情况,百度也会提示抓取失败。

5,刷新CDN缓存/http错误!

如果以上都没有错误,那么你就要检查你的CDN了,很可能是因为CDN缓存而造成的,或者是你配置了https,而站长平台却绑定的http,无法访问,这两点自己排查,如果以上都做到,那么是不会提示这类错误的,当然也不排查百度站长平台本身的问题,不过这种机率性很小。

文章来源:代代SEO博客

来源地址:https://www.daidaiseo.com/seoti/410.html

站长资讯网

站长资讯网